Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- 빅데이터처리

- word2vec

- 빅데이터

- ggplot

- NLP

- 딥러닝

- r

- 자연어처리

- 하둡

- 머신러닝

- 기계학습

- Deeplearning

- pandas

- Python

- 데이터시각화

- 그래프

- Hadoop

- 주가예측

- CNN

- HIVE

- 그래프시각화

- SQL

- R그래프

- 데이터분석

- R시각화

- AI

- R프로그래밍

- 데이터처리

- lstm

- 데이터

Archives

- Today

- Total

욱이의 냉철한 공부

[딥러닝 기본] Deep learning 학습개념 2 본문

* 출저

본 개념정리는 제 담당교수님이신 연세대학교 정보대학원 김하영 교수님 수업과 Andrew 교수님의 Coursera 수업을 통해 얻은 정보를 통해 정리했습니다. 자료는 Andrew 교수님의 Coursera 수업자료입니다.

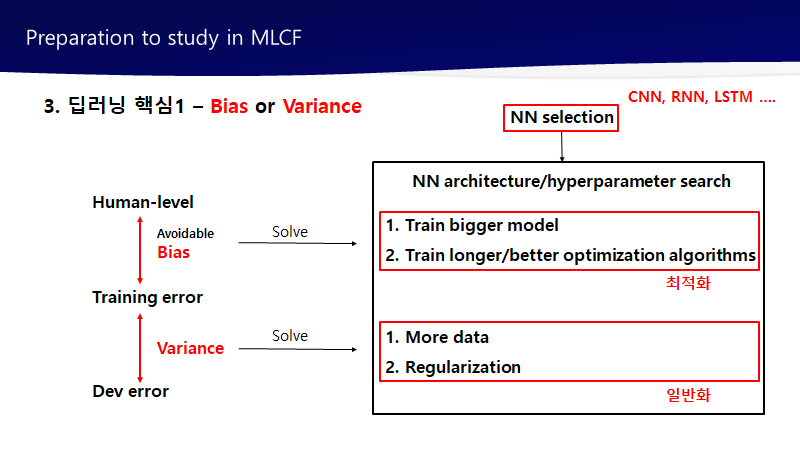

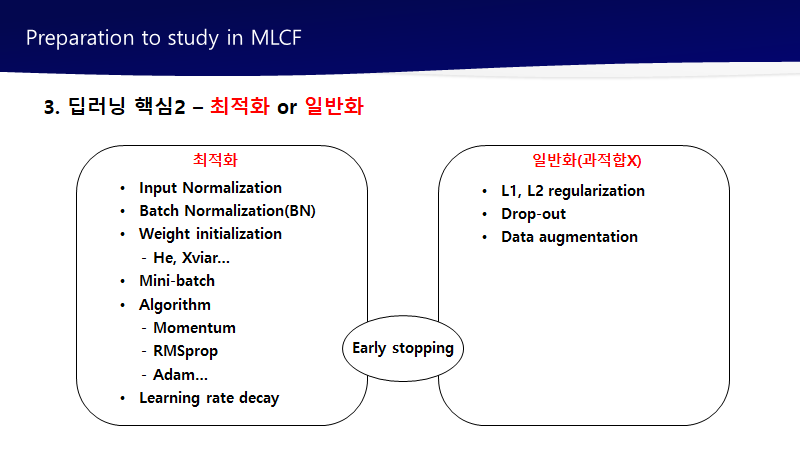

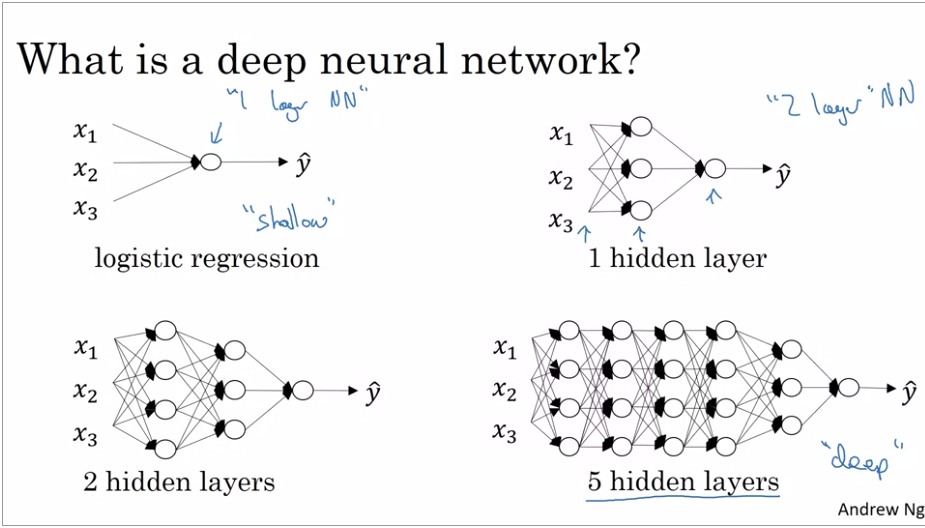

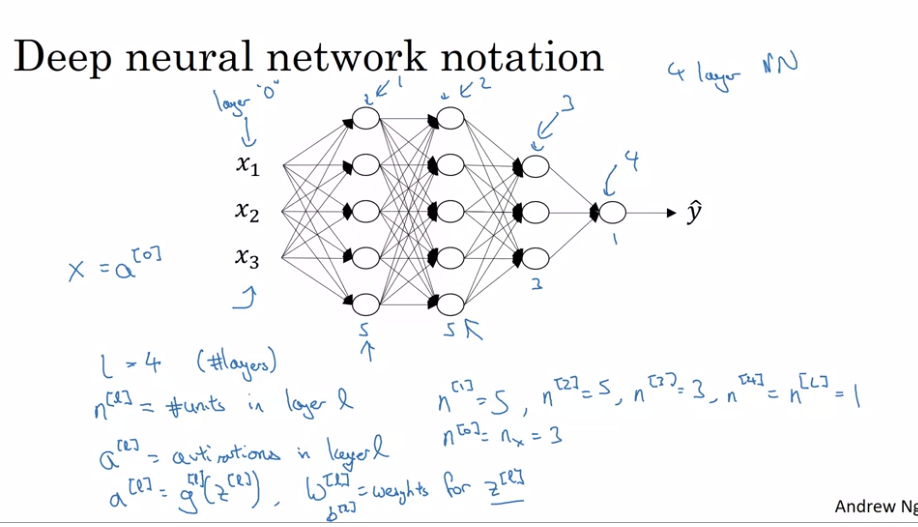

1. Deep L-layer neural network

- What is a deep neural network?

로지스틱 회귀분석 모델을 굉장히 "shallow"한 모델이라고 표현

반면에 층이 2개 이상인 모델은 "deeper model"이라고 표현

shallow와 depth의 차이는 결국 그 정도의 차이

* 신경망의 층을 세는 경우, 입력값의 층은 세지 않는다.

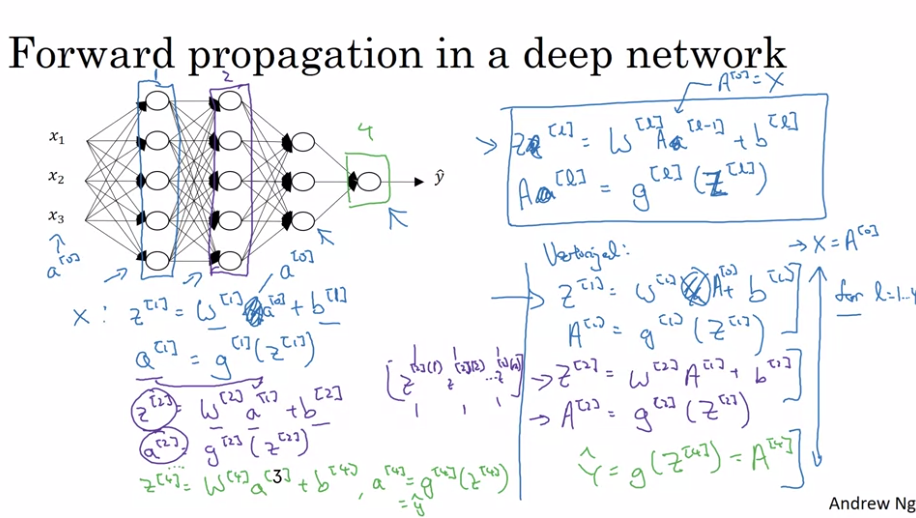

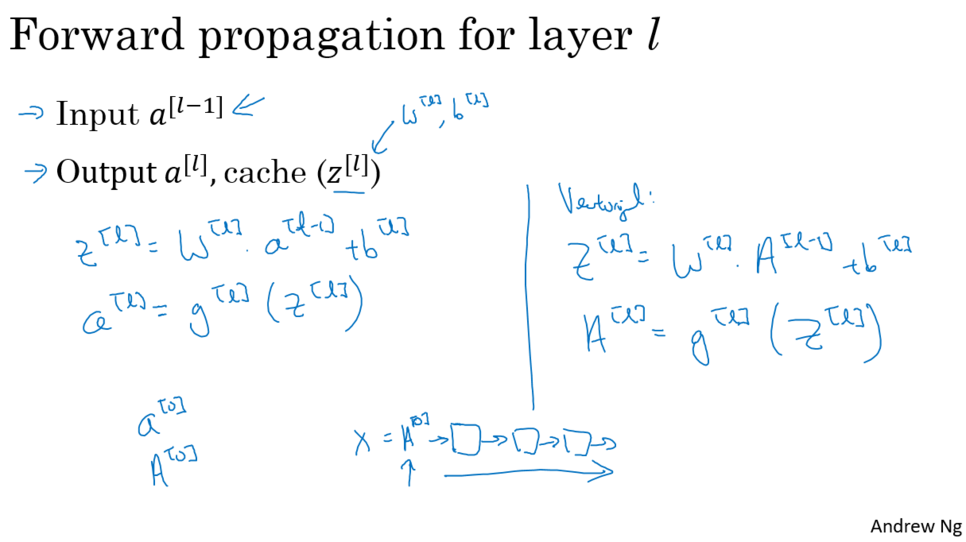

2. Forward propagation in a deep network

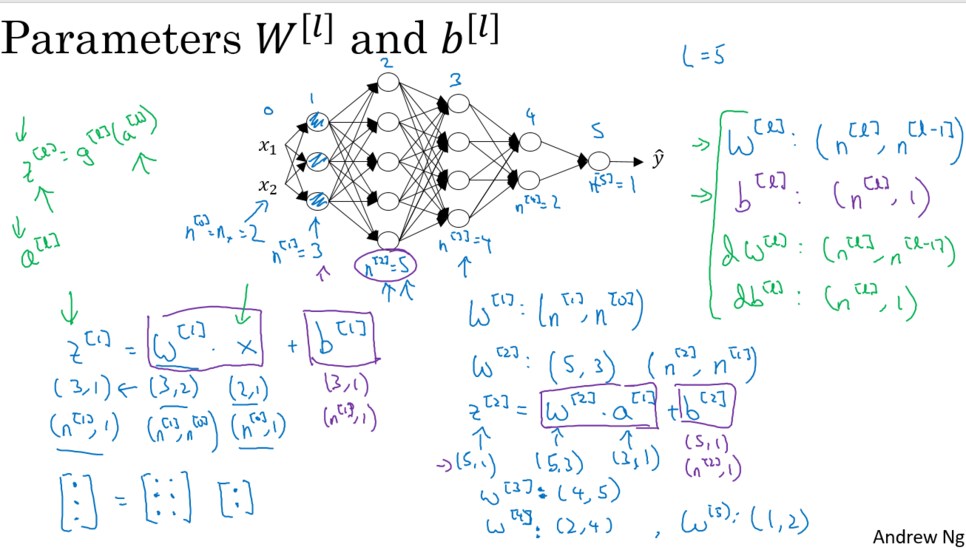

3. Getting your matrix dimensions right

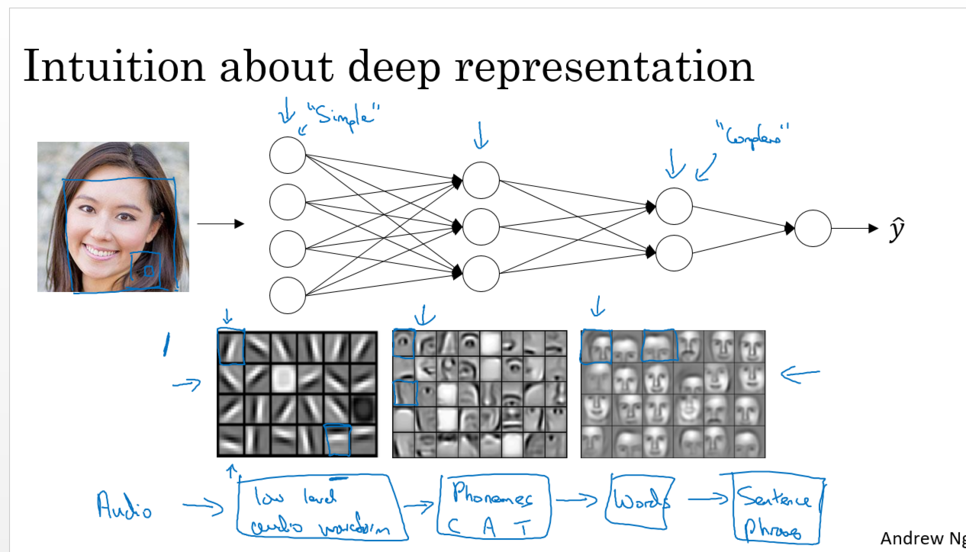

4. Why deep representation

- deep nueral network 특징

낮은 층(입력에 가깝다) : 낮은 수준. 미세한 부분, “경계”같은 단순한 형태, 간단한 함수

높은 층(출력에 가깝다) : 더 높은 수준. 여러 가지 특징들 추출하여 조합하면서 올라간다. 복잡한 함수.

ex) 음성인식 : 높낮이 -> 음소 -> 단어 -> 문장전체

- deep nueral network 핵심

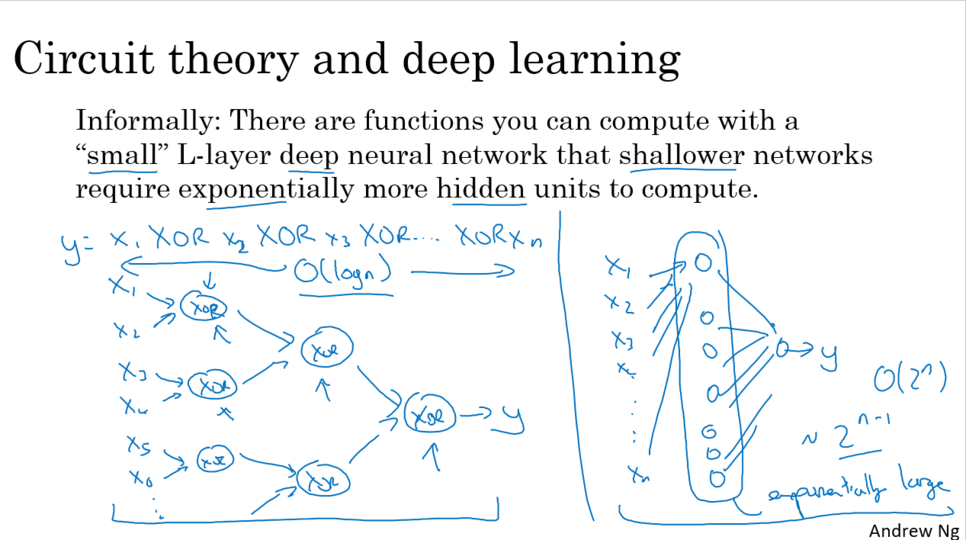

1. 모델 크기 커지면 표현력 풍부해진다.

2. 파라미터를 아껴 연산을 더 적게 할 수 있다. (피피티 자료 2번째)

* Lelu함수가 딥러닝에 미친 영향

1. 기울기 소실 문제 제거

2. 계산량 쉽게 만들었다.

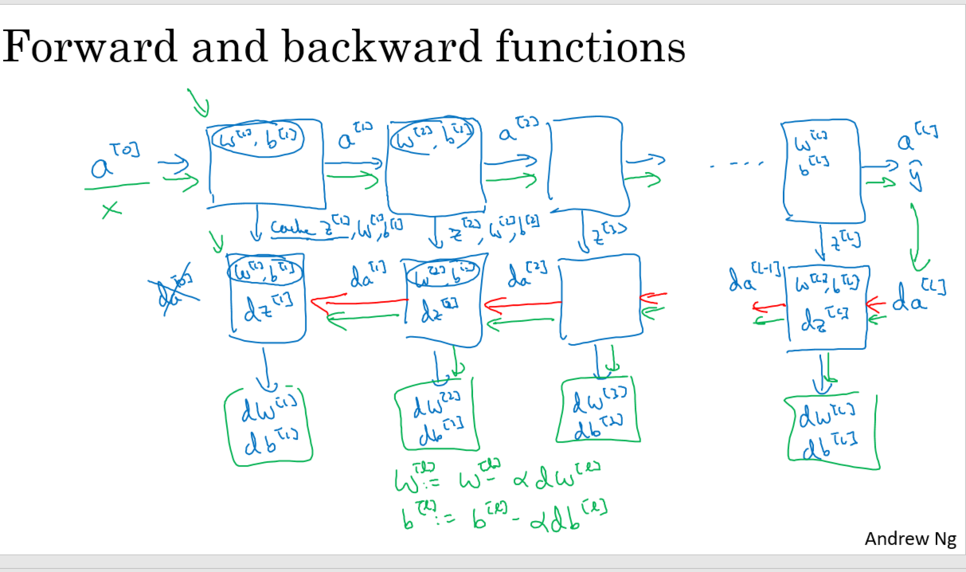

5. Building blocks of deep neural networks

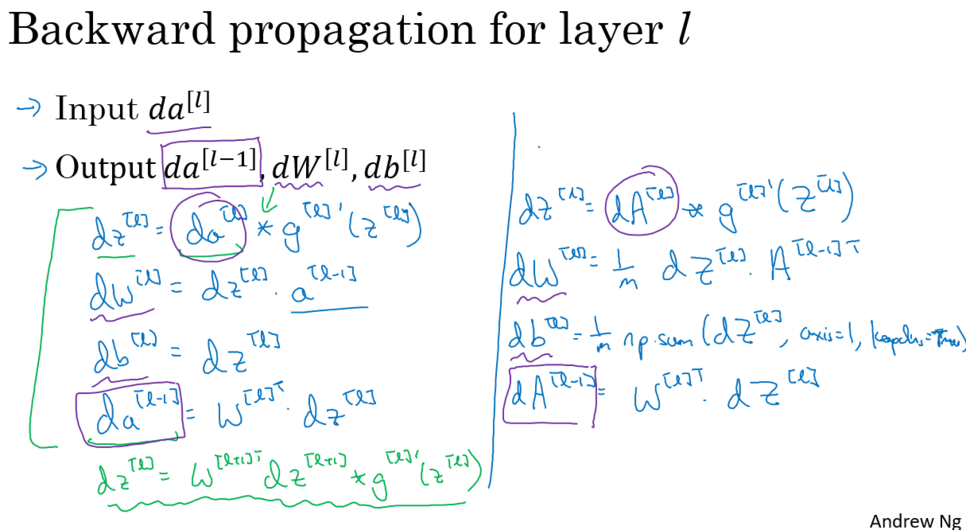

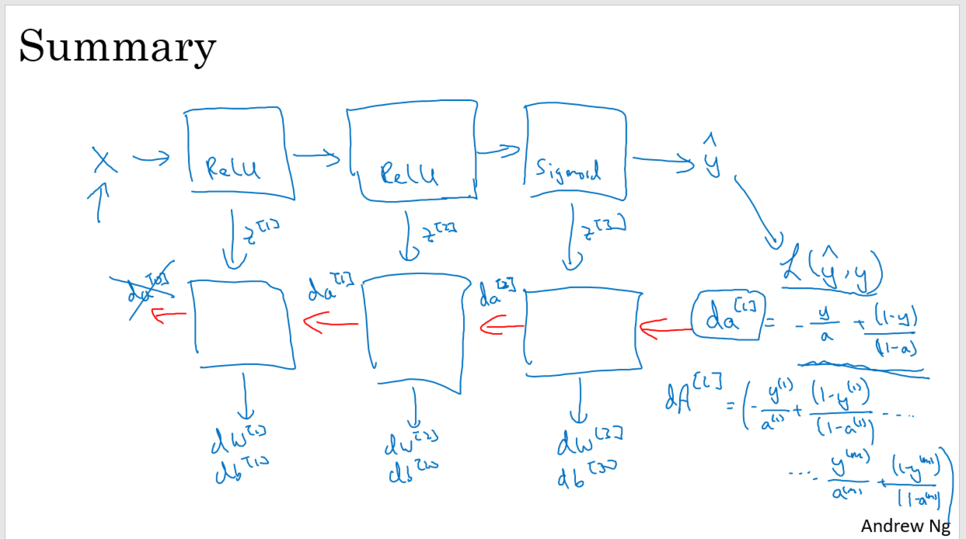

6. Forward and Backward Propagation

* 핵심부분

각 layer에서 dz가 재귀함수마냥 그 전 층, 전전 층의 기울기를 (마지막은 출력층) 계속 이어받는다.

이것은 활성화 함수에서의 기울기를 계속 이어 받는 것과 같다.

즉 기울기는 입력층으로 가까워질수록 작아질 수 밖에 없다.

이것을 해결해야 '최적화'를 성취한다.

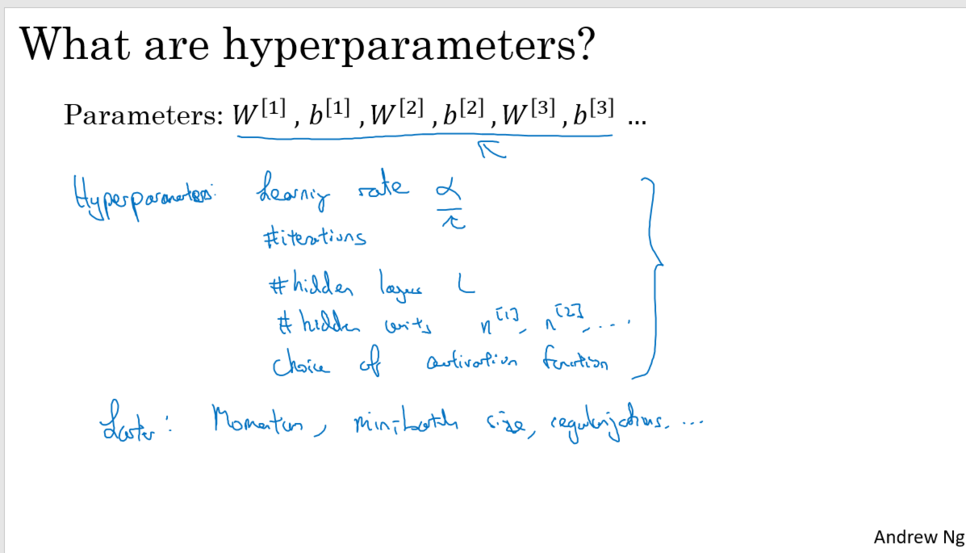

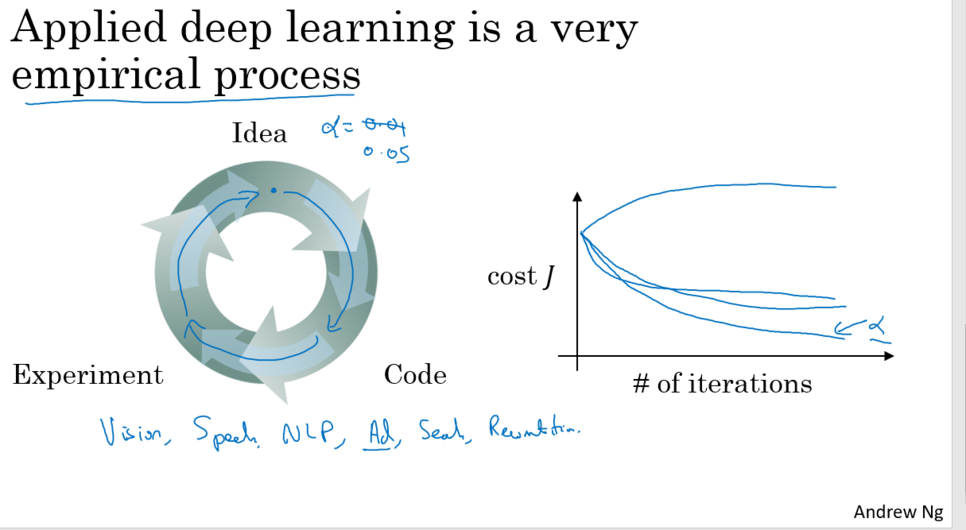

7. Parameters vs Hyperparameters

- 하이퍼파라미터

파라미터를 결정하는 파라미터

'데이터과학 > 개념 : Deep Learning' 카테고리의 다른 글

| [딥러닝 기본] Deep Learning 학습최적화 셋팅 (0) | 2022.03.28 |

|---|---|

| [딥러닝 기본] Setting up your ML application (0) | 2022.03.28 |

| [딥러닝 기본] Deep Learning 핵심개념 : Feature추출에 대한 이해 (1) | 2020.06.22 |

| [딥러닝 기본] Deep Learning 학습최적화 개선 (0) | 2020.06.21 |

| [딥러닝 기본] Deep Learning 과적합 해결 (0) | 2020.06.21 |